協調制御による遠隔操作支援(Shared Control For Enhanced Teleoperation)

本研究テーマでは、誰もが熟練者のように遠隔ロボットを操作することを可能にする協調制御手法について研究開発を行なっております。 協調制御では、AIによる環境認識、軌道生成、把持計画、衝突回避を活用し、人の操作入力と組み合わせることで、直感的かつ作業効率の良い遠隔操作を実現します。 従来の遠隔操作では、通信遅延や感覚フィードバックの欠落による操作性の低下が問題となっています。 知能を伴う操作支援を行うことにより、様々な場面においても高い操作性を維持可能な遠隔操作システムの構築に取り組みます。 また、本研究テーマは日本 (Nagoya University)、ドイツ (Technische Universität Darmstadt)、フランス (École Centrale de Lyon)で構成される国際研究チームにて共同で行なっております。

遠隔操作のための接触式触覚インタフェイス開発

従来の遠隔操作インタフェイスでは、遠隔操作時の触覚フィードバックとして、主に力覚の伝送について研究開発されてきました。 しかし、In-Hand Pivotingのような既に把持された対象物の姿勢が手中で常に変化し、目標の姿勢へと調整する器用な操作では、接触面の法線方向力に加えせん断力の提示が重要です。 せん断力の提示により、把持物表面の滑りや姿勢の変化を随時に知覚することが可能となります。 開発した接触式触覚インタフェイスでは、多点接触式を採用することにより、引っ張るやねじるといったより複雑な皮膚変形を生成でき、把持対象物の手中での姿勢変化を忠実に提示できます。 本研究の成果は、日刊工業新聞にて取り上げられました(日刊工業新聞, ニュースイッチ)。

触覚センサの遠隔操作への応用

近年、視覚ベースの触覚センサは、ロボティクス分野や機械学習分野で広く注目を集めています。 これらの触覚センサは、ロボットハンドが把持した物体を操作する際に接触情報、すなわち触覚情報を抽出できると期待されています。 このような触覚センサの性質は、遠隔操作において触覚フィードバック系を構築するのに最適です。 本研究では、視覚ベースの触覚センサDIGITやGelsightを使用し、機械学習を用いた接触力推定方法を提案し、推定した力情報バイラテラル制御と連携することで力のフィードバックを行います。 また、接触面の法線方向力に加え、せん断力を推定し接触式触覚インタフェイスと組み合わせることで、触覚フィードバックの可能性を広げます。

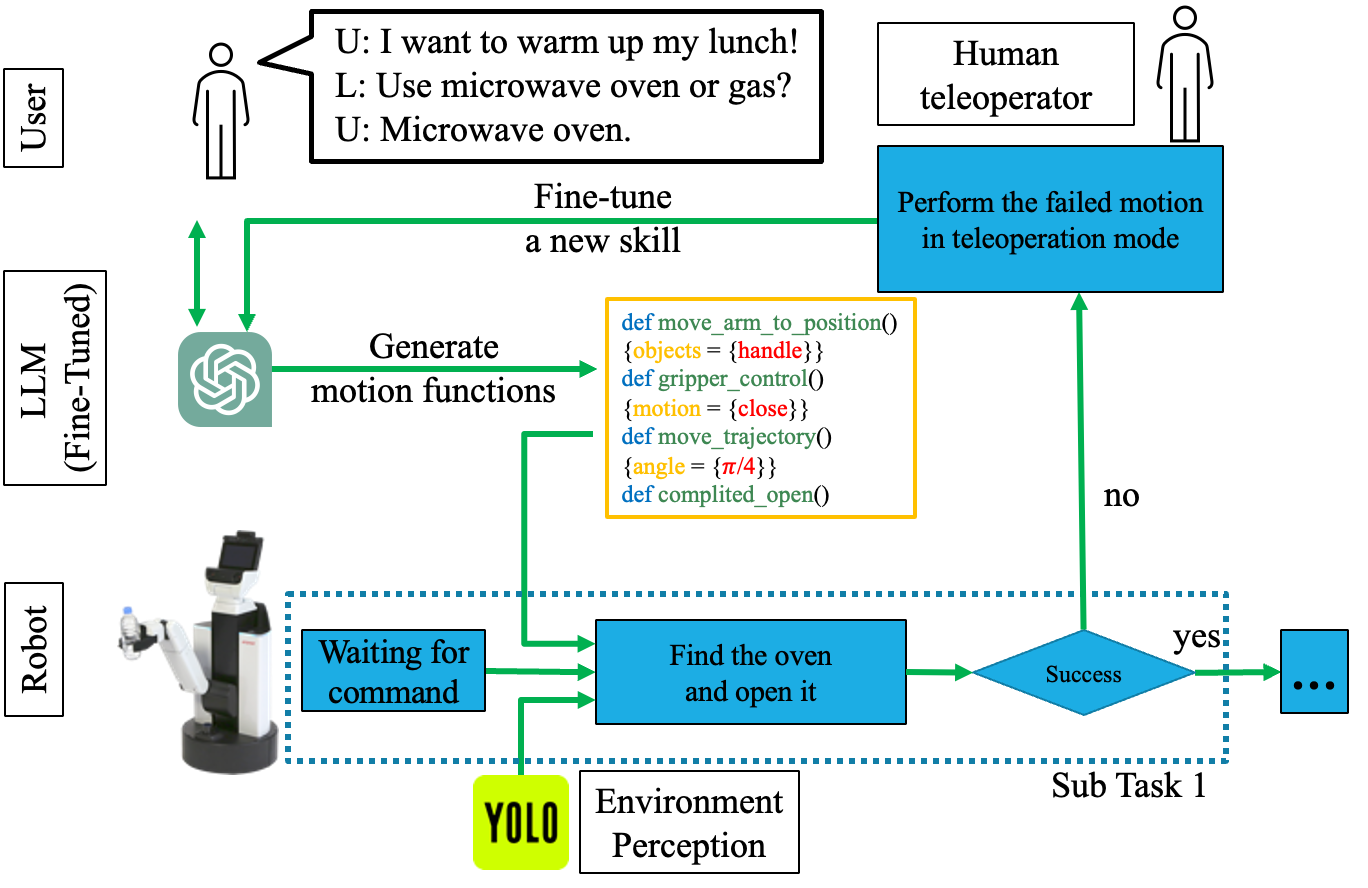

大規模言語モデルおよび Human Robot Collaboration による自律ロボットの汎用性向上

本研究では、大規模言語モデル(Chat-GPT)による推論能力を活用し、高レベルの言語コマンドを実行可能な動作シーケンスに変換することで、汎用性の高い自律ロボットを実現します。 提案するシステムは、大規模言語モデルとYOLOによる環境認識を組み合わせ、与えられたコマンドに基づいてロボットが実世界で自律的に合理的な判断とタスク計画を行うことを可能にします。 さらに、大規模言語モデルに起因する行動計画の不正確さに対処するため、遠隔操作を用いた動作教示と動作プリミティブ(Movement Primitives)の連携により、自律ロボットの行動を修正し、追加学習を通してその汎用性を向上させます。